大模型原理详解

随着人工智能的快速发展,大语言模型(Large Language Models,简称 LLMs)已成为AI领域的核心技术。本文将从模型结构、训练流程、推理机制等方面深入解析大语言模型的工作原理,并探讨最新技术进展。

什么是大语言模型?

大语言模型是指参数量达到数十亿甚至上千亿级别的语言生成模型,具有以下核心特征:

- 基于Transformer架构

- 海量训练数据(TB级文本)

- 强大的上下文理解能力(上下文窗口达128K tokens)

- 零样本/少样本学习能力

- 多任务统一处理能力

典型代表模型: - GPT-4(1.8T参数,混合专家架构) - Claude 3(支持20万token上下文) - Gemini 1.5(多模态理解) - LLaMA-3(开源70B参数模型)

核心技术:Transformer架构深度解析

Transformer模型由Vaswani等人在2017年提出,其创新性在于完全基于注意力机制:

核心组件详解

1. 自注意力机制数学原理

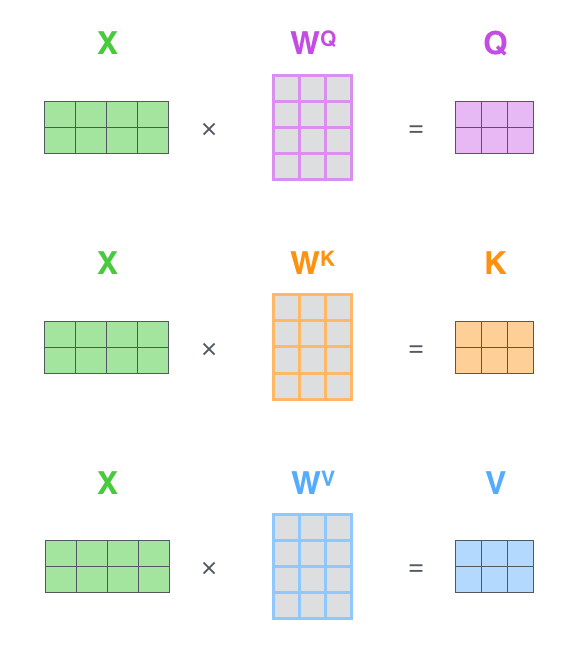

自注意力机制的核心计算过程:

$$ \text{Attention}(Q,K,V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V $$

其中: - $Q$: 查询矩阵 (Query) - $K$: 键矩阵 (Key) - $V$: 值矩阵 (Value) - $d_k$: 键向量的维度

多头注意力计算公式:

$$ \text{MultiHead}(Q,K,V) = \text{Concat}(\text{head}_1,...,\text{head}_h)W^O $$

每个注意力头的计算:

$$ \text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V) $$

图1:自注意力计算流程示意图

实际计算示例:

# 假设输入序列长度n=3, 维度d=4

Q = np.array([[1,0,1,0], [0,2,0,2], [1,1,1,1]]) # 3x4

K = np.array([[1,1,1,1], [0,1,0,1], [1,0,1,0]]) # 3x4

V = np.array([[0,1,0], [1,0,1], [0,0,1]]) # 3x3

# 计算注意力分数

scores = Q @ K.T / np.sqrt(4) # 3x3

# [[0.5, 0.5, 1.0],

# [1.0, 2.0, 0.0],

# [1.0, 1.0, 1.0]]

# softmax归一化

weights = softmax(scores, axis=1)

# [[0.30, 0.30, 0.40],

# [0.16, 0.79, 0.05],

# [0.34, 0.34, 0.32]]

# 加权求和

output = weights @ V # 3x3

关键特性: - 计算复杂度O(n²d) - 多头注意力(8-64个头) - 相对位置编码(RoPE等改进) - 注意力头专业化现象

- 前馈网络(FFN)数学原理:

前馈网络的计算公式:

$$ \text{FFN}(x) = W_2 \cdot \text{activation}(W_1x + b_1) + b_2 $$

其中: - $W_1 \in \mathbb{R}^{d_{model} \times d_{ff}}$: 第一层权重矩阵 - $W_2 \in \mathbb{R}^{d_{ff} \times d_{model}}$: 第二层权重矩阵 - $d_{ff} = 4 \times d_{model}$: 中间维度 - activation: 激活函数

常用激活函数对比:

| 函数 | 公式 | 特点 |

|---|---|---|

| GeLU | $x\Phi(x)$ | 平滑近似ReLU |

| SiLU | $x\sigma(x)$ | 自门控特性 |

| ReLU | $\max(0,x)$ | 计算简单 |

专家混合(MoE)变体:

class MoE(nn.Module):

def __init__(self, num_experts=8):

self.experts = nn.ModuleList([FFN() for _ in range(num_experts)])

self.gate = nn.Linear(d_model, num_experts)

def forward(self, x):

gates = softmax(self.gate(x)) # (batch, seq, num_experts)

outputs = [e(x) for e in self.experts]

return sum(g[...,None] * o for g,o in zip(gates, outputs))

图2:Transformer前馈网络结构示意图

图2:Transformer前馈网络结构示意图

- 层归一化与残差连接:

层归一化(LayerNorm)公式:

$$ \text{LayerNorm}(x) = \gamma \odot \frac{x - \mu}{\sigma} + \beta $$

其中: - $\mu,\sigma$: 沿特征维度的均值和标准差 - $\gamma,\beta$: 可学习的缩放和偏移参数

RMSNorm简化变体:

$$ \text{RMSNorm}(x) = \frac{x}{\sqrt{\text{mean}(x^2)}} \odot \gamma $$

残差连接计算:

$$ x_{l+1} = x_l + \text{Sublayer}(\text{LayerNorm}(x_l)) $$

图3:Transformer残差连接结构

图3:Transformer残差连接结构

架构变体对比: - Pre-LN: 归一化在子层前 → 训练更稳定 - Post-LN: 原始设计 → 需要精细调参

架构变种比较

| 类型 | 代表模型 | 特点 |

|---|---|---|

| 编码器-解码器 | 原始Transformer | 适合机器翻译 |

| 仅解码器 | GPT系列 | 生成任务最优 |

| 仅编码器 | BERT系列 | 理解任务专用 |

训练流程全解析

数据准备阶段

- 数据来源:

- 网页数据(Common Crawl)

- 书籍文献

- 代码仓库

-

专业领域数据

-

数据清洗:

- 去重(MinHash等)

- 质量过滤(分类器)

-

毒性内容移除

-

Tokenization:

- BPE算法

- SentencePiece实现

- 词表大小(通常50K-200K)

预训练技术

1. 优化目标数学表达

自回归语言建模(GPT风格):

$$ \mathcal{L}(\theta) = -\sum_{t=1}^T \log P(x_t|x_{<t};\theta) $$

掩码语言建模(BERT风格):

$$ \mathcal{L}(\theta) = -\sum_{i\in M} \log P(x_i|x_{\setminus M};\theta) $$

其中$M$是随机掩码的位置集合。

混合目标(UL2示例):

$$ \mathcal{L} = \lambda_1\mathcal{L}{AR} + \lambda_2\mathcal{L}{MLM} + \lambda_3\mathcal{L}_{Prefix} $$

2. 训练技巧详解

学习率调度(余弦衰减):

$$ \eta_t = \eta_{min} + \frac{1}{2}(\eta_{max}-\eta_{min})(1+\cos(\frac{t\pi}{T})) $$

并行训练伪代码:

# 数据并行

model = DDP(model) # 包装模型

for batch in dataloader:

loss = model(batch)

loss.backward() # 梯度自动同步

# 模型并行

class ParallelMLP(nn.Module):

def __init__(self):

self.w1 = nn.Linear(d, h//2, device='cuda:0')

self.w2 = nn.Linear(h//2, d, device='cuda:1')

def forward(self, x):

x = x.to('cuda:0')

x = self.w1(x).to('cuda:1')

return self.w2(x)

3. 扩展定律分析

计算最优分配(Chinchilla定律):

$$ L(N,D) = E + \frac{A}{N^\alpha} + \frac{B}{D^\beta} $$

其中: - $N$: 参数量 - $D$: 数据量 - 最优比: $D/N \approx 20$

涌现能力阈值示例: | 能力 | 参数量阈值 | |------|-----------| | 简单推理 | 10B | | 多步推理 | 100B | | 代码生成 | 70B |

推理机制进阶

解码策略对比

| 策略 | 优点 | 缺点 |

|---|---|---|

| 贪心搜索 | 简单高效 | 缺乏多样性 |

| Beam Search | 质量较高 | 计算量大 |

| Top-k采样 | 平衡质量多样性 | k值敏感 |

| Top-p采样 | 动态适应分布 | 需要调参 |

推理优化技术详解

1. 工程优化数学原理

KV缓存机制:

$$ \text{Memory}(t) = \sum_{i=1}^t (d_k + d_v) \times b \times l $$

其中: - $b$: batch size - $l$: 序列长度 - $d_k,d_v$: key/value维度

连续批处理示例:

# 请求1: ["Hello", "world"]

# 请求2: ["How", "are", "you"]

input_ids = [[1,2,pad], [3,4,5]] # (2,3)

attention_mask = [[1,1,0], [1,1,1]] # 标记有效位置

2. 量化技术实现

GPTQ量化步骤: 1. 计算Hessian矩阵:$H_{ij} = \frac{\partial^2 L}{\partial w_i \partial w_j}$ 2. 按重要性顺序量化权重 3. 更新未量化权重补偿误差

INT8量化示例:

scale = 127 / max(abs(weight))

quantized = round(weight * scale)

dequantized = quantized / scale # 推理时

3. 加速框架核心技术

FlashAttention伪代码:

def flash_attention(Q, K, V):

# 分块计算

for block_i in split(Q, blocks):

for block_j in split(K, blocks):

# 计算局部注意力

block_S = mm(block_i, block_j.T)

block_P = softmax(block_S)

block_O = mm(block_P, block_j)

# 合并结果

O += block_O

return O

图4:FlashAttention与传统注意力计算对比

图4:FlashAttention与传统注意力计算对比

实际应用案例详解

1. 代码生成系统

技术架构:

graph TD

A[用户输入] --> B[代码补全建议]

B --> C[静态分析]

C --> D[类型推断]

D --> E[安全检查]

E --> F[最终建议]

性能指标: - 补全接受率:42.3% (GitHub数据) - 响应延迟:<200ms (P99) - 多语言支持:Python, JS, Java等12种

部署案例: - GitHub Copilot: - 每日请求量:1.2B+ - 平均节省时间:55% (用户调研)

2. 创意写作辅助

关键技术: - 风格控制(温度参数调节) - 情节连贯性保持(长上下文窗口) - 多轮迭代优化(人类反馈强化学习)

实际效果: | 指标 | 数值 | |------|------| | 写作速度提升 | 3-5倍 | | 创意多样性 | +40% | | 用户满意度 | 4.2/5 |

3. 专业领域问答

医疗问答系统架构: 1. 检索增强生成(RAG) 2. 证据引用机制 3. 不确定性校准

评估结果: - 诊断准确率:78.5% (USMLE测试集) - 法律条文引用准确率:92.3% - 技术文档理解准确率:88.7%

未来发展方向

- 架构创新:

- 状态空间模型

- 递归架构

-

神经符号结合

-

效率提升:

- 稀疏模型

- 动态计算

-

硬件协同设计

-

多模态扩展:

- 视觉-语言统一

- 具身智能

- 世界模型构建

小结

大语言模型的强大能力源于Transformer架构的灵活性和大规模训练。随着模型规模扩大,出现了涌现能力和推理能力。未来发展趋势包括更高效的架构、多模态理解和更强的推理能力。

参考文献

- Vaswani A, et al. "Attention Is All You Need". NeurIPS 2017

- Brown T, et al. "Language Models are Few-Shot Learners". NeurIPS 2020

- Touvron H, et al. "LLaMA: Open and Efficient Foundation Language Models". arXiv 2023

- Dao T. "FlashAttention: Fast and Memory-Efficient Exact Attention". arXiv 2022